新しい統合モデル「SAM 3」が公開されました。画像と動画をまたいで、物体の検出・セグメンテーション(領域分割)・トラッキング(追跡)を一つのモデルで実現し、テキストや類例(エグザンプラ)によるプロンプト指定で、特定カテゴリの対象を一括抽出できるのが特徴です。学習成果はInstagramの「Edits」や「Vibes」にも反映され、クリエイターの高度な編集体験を後押しします。

概要

SAM 3とは何か

SAM 3は、画像・動画の両方で通用する「統合」モデルです。これまで別々に扱われがちだった検出、セグメンテーション、トラッキングを単一の枠組みにまとめ、同じ操作感でオブジェクトの抽出や追跡が行えます。

テキスト&類例プロンプトに対応

ユーザーは「テキスト(例:『すべての犬』)」や「類例(参考画像・領域の例示)」で指示し、対象カテゴリに属する全オブジェクトを一括でセグメント可能。細かなマスク作成の手間を大幅に減らせる点が注目されています。

できることと活用シーン

検出・分割・追跡の統合による効率化

同一モデルで検出→分割→追跡まで一気通貫で扱えるため、ワークフローがシンプルになります。動画内の対象を一度指定すれば、フレームをまたいで追跡し、不要なフレーム毎の手作業を削減できます。

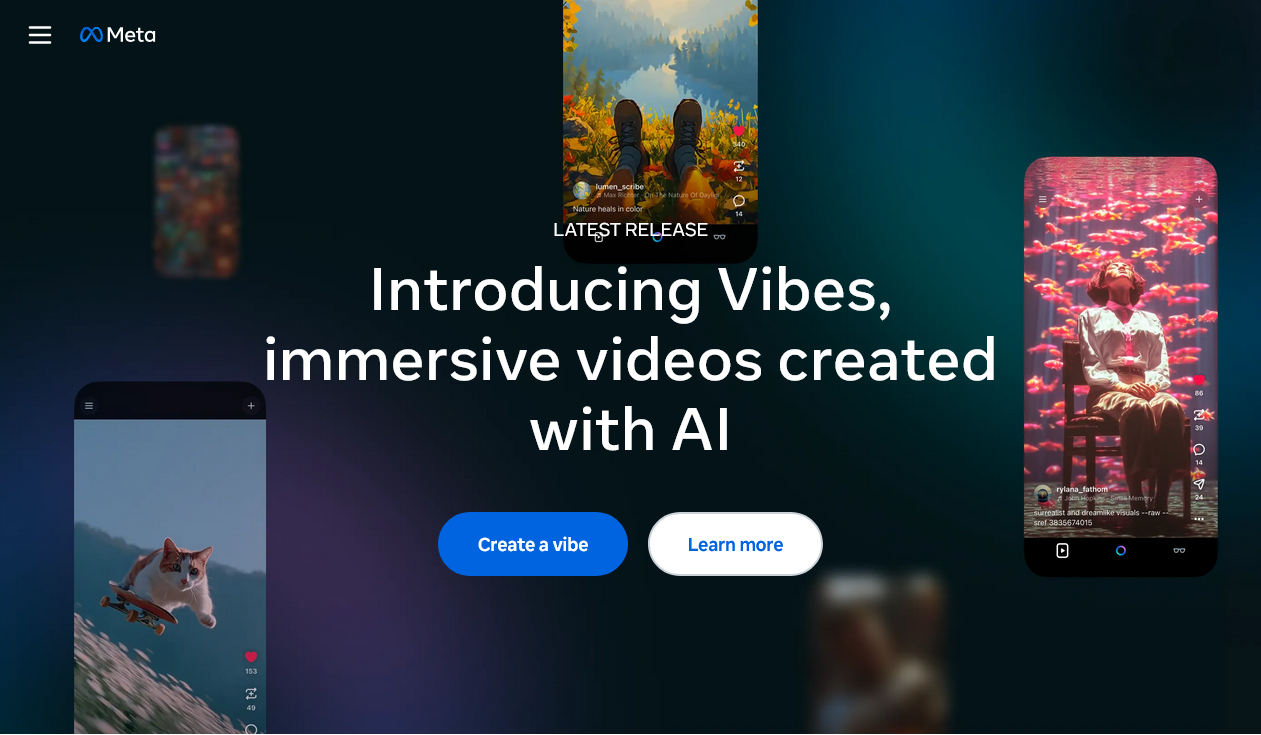

Instagram「Edits」「Vibes」への展開

SAM 3で得られた知見は、Instagramの編集機能「Edits」や雰囲気づくりに関わる「Vibes」に反映予定。クリエイターはアプリ内でより精密な切り抜きや対象指定、映像の一括加工などを簡単に行えるようになる見込みです。

具体的なユースケース例

テキストや類例で対象を指定できるため、以下のような使い方が想定されます。

- 動画編集:被写体だけを自動追跡してカラーグレーディングやエフェクトを適用

- クリエイティブ制作:複数の同カテゴリの物体を一括選択して合成・置換

- EC・広告:商品だけを素早く切り抜き、背景差し替えや一括レタッチ

- 調査・分析:人や車などのカテゴリ単位で動きや出現数を可視化

技術的ポイントと留意事項

プロンプト指示の柔軟性

テキストと類例プロンプトの併用で、抽出対象の条件指定が柔軟になります。カテゴリやスタイルの曖昧さを補い、意図した対象に素早く近づけることができます。

精度・計算負荷・倫理面の配慮

高度な分割・追跡ほど計算コストや推論時間が増える可能性があり、利用環境に合わせた設定が重要です。また、誤検出・見落としやカテゴリ定義の曖昧さ、データバイアスへの配慮も不可欠です。

総括

まとめ

SAM 3は、テキスト/類例プロンプトと統合処理により、画像・動画編集の実務を大きく効率化し得る基盤モデルです。Instagramへの展開によって、専門ツールに依存せずモバイル環境でも高度な切り抜きや追跡が使いやすくなることが期待されます。最新仕様や提供形態は今後の案内に注目しましょう。